【AAAI2021】A Novel Visual Interpretability for Deep Neural Networks by Optimizing Activation Maps with Perturbation 一种新的深度神经网络的视觉可解释性

摘要:

可解释性一直被视为部署深度神经网络的一个重要组件,基于显著性的方法是最流行的可解释的方法之一,因为它可以生成单独直观的热图,突出部分输入图像最重要的决定深度网络在一个特定的分类目标。然而,由现有方法生成的热图要么包含很少的表示对象的信息(基于扰动的方法),要么不能有效地定位多类对象(基于激活的方法)。为了解决这个问题,设计了一个可视化深度神经网络可解释性的两阶段框架,称为扰动优化激活(AOP),以优化一般基于扰动的方法和基于扰动的方法生成的激活图。最后,为了更好地解释不同类型的图像,我们进一步提出了AOP框架的一个实例,即基于平滑集成梯度的类激活图(SIGCAM),该实例提出了一种应用特征图作为权重系数的加权梯度CAM

1. 引言

现有方法:

- 将梯度或其变体反向传播到输入图像中,以决定哪些像素或区域与预测的变化更相关=>这些变化不一定表明像素或区域对预测有重大影响。

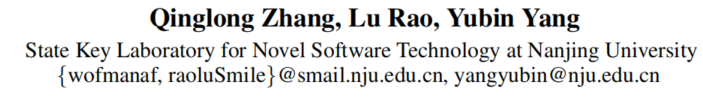

(如下图:softmax层后的分类得分:双体船:0.521,海盗0.068。故逐渐将海盗进行mask并测试对于双体船的影响。结果表明:删除“海盗”对“双体船”的分类得分有显著影响,但与“双体船”无关)

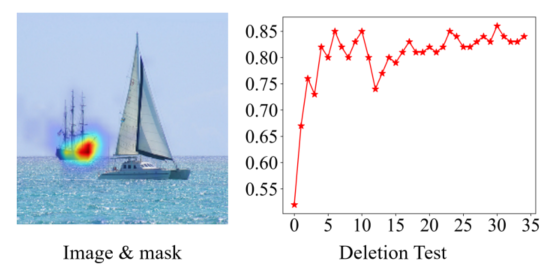

- 基于激活的方法(如GradCAM)=>使用反向传播梯度作为权重来组合前向特征图=>这些方法可能会捕获很多毫无意义的信息,因为特征映射并不一定与目标类别相关

- 基于扰动的方法(如EMP,I-GOS)=>采用梯度作为掩模=>生成的热图可能包含的用于表示对象的信息很少

本文贡献:本文提出平滑集成梯度类激活图SIGCAM,首先使用加权梯度WGradCAM生成表现良好base-mask在不同类型的图像上,然后使用I-GOS优化生成的base-mask。

- 引入了一个高度灵活的两阶段框架AOP,结合基于激活的方法的优势来捕获足够的信息和基于扰动的方法生成网络决策相关掩模的能力

- 我们提出了GradCAM的扩展WGradCAM,通过将特征映射作为权重系数,它与GradCAM++相似,但更简单、更有效。

- 提出了SIGCAM,AOP的一个特殊实例,它使用I-GOS来优化所提出的WGradCAM

2. 相关工作

可解释性方法:

- 基于梯度的方法

- 基于激活的方法

- 基于区域的方法

- 基于扰动的方法

3. 方法

AOP(Optimizing Activation with Perturbation使用扰动优化激活)

基于扰动方法允许我们直接估计出输入像素的影响,并生成更人性化的显著性映射。

=>存在问题:它们的效率较低,而且优化过程需要数百次迭代。

基于激活的方法能够快速生成显著性映射,从而获取更多关于目标对象的信息。

AOP的思想:应用基于激活的方法来生成base-mask,并利用基于扰动的方法对其进行优化。AOP的base-mask可以通过不同类型的基于激活的方法生成,优化过程可以通过各种基于扰动的方法进行,使AOP框架具有高度的可扩展性。

WGradCAM(Weighted GradCAM 加权GradCAM)

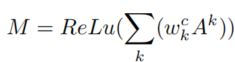

,

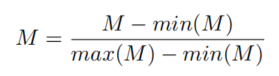

, M可以使用基于扰动的方法进行优化。

M可以使用基于扰动的方法进行优化。

SIGCAM

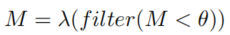

由于M包含了很多非零像素,所以直接优化M很耗时/bask-mask中太多像素值较高,对人类不友好=>使用滤波器过滤掉小于阈值的像素,并使用调制因子λ将其控制在一个特定范围。

然后将M上采样到大小小于输入图像形状的矩阵,作为基掩膜。

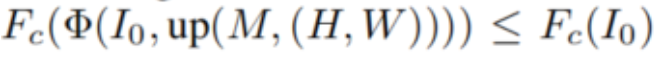

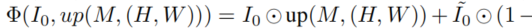

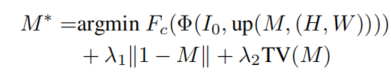

本文在微调的过程中,找到M 的最小掩膜M*使得 ,其中

,其中 ,

, 表示把M上采样到(h1,w1)的大小。

表示把M上采样到(h1,w1)的大小。

其中 表示一个和I0大小一致的baseline图像,但是在类别c上的评分很低。

表示一个和I0大小一致的baseline图像,但是在类别c上的评分很低。

最后可以用M∗来最小化以下目标函数:

其中||1-M||是l1正则化,TV(M)是第二项全变范数,使M更分段平滑

4. 实验

数据集:ImageNet-1k、COCO2017(许多图像是多目标多类的)

度量方式:

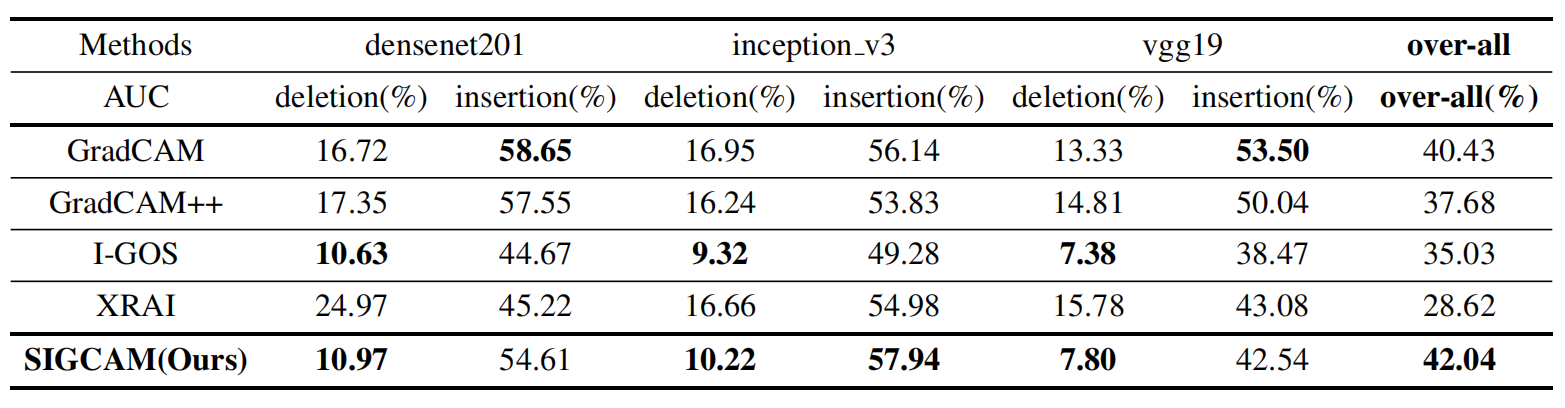

deletion:删除与类最相关的像素/区域将导致分类分数显著下降(AUC越小越好)

insertion:从模糊的图像开始,逐渐重新引入内容,产生更真实的图像,并具有减轻对抗攻击的示例的影响。(AUC越大越好)

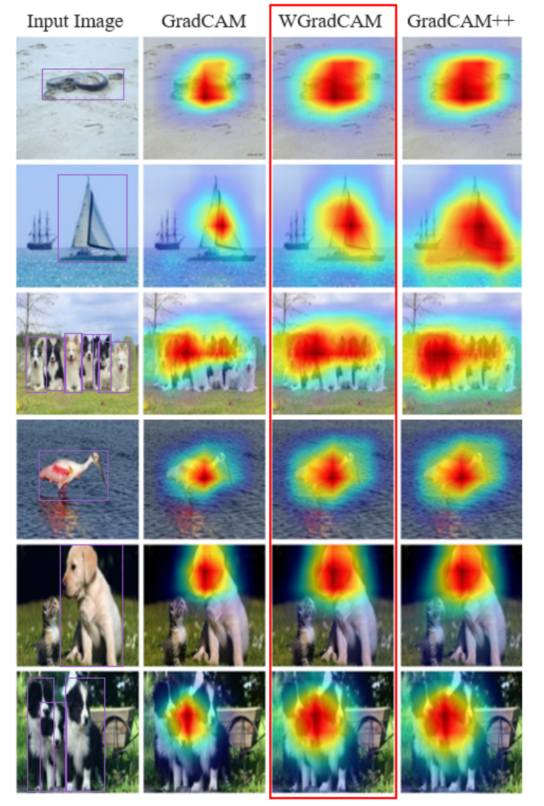

验证WGradCAM的有效性:

GradCAM对于”多目标,单类别”效果显著下降,GradCAM++对于“多目标,多类别”包含了不相关信息

与其他显著性方法进行对比。

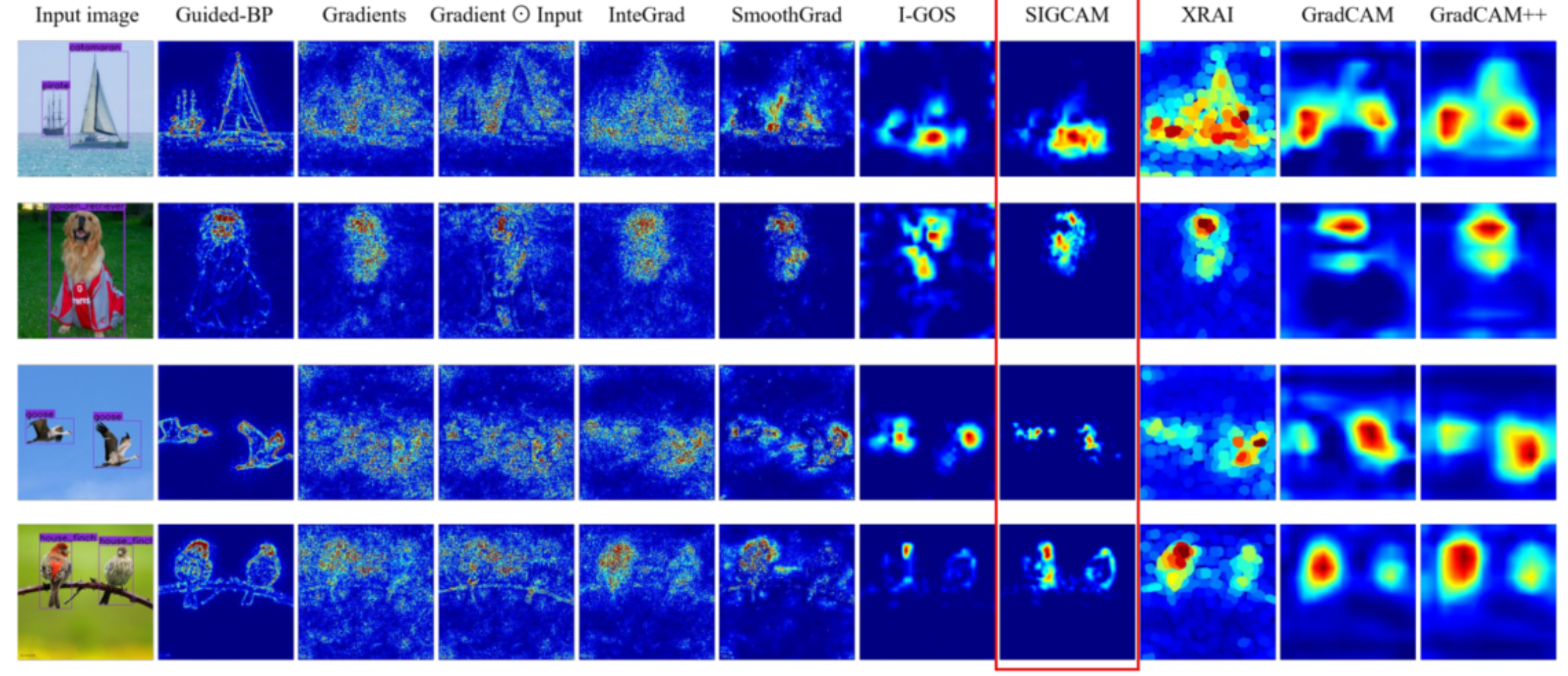

如下图所示,Guided-bp生成的热图比其他基于梯度的方法生成的热图更有意义。vanilla

Back-propagation, Integrated Gradients, and SmoothGrad的显著性图噪声太多,看起来不那么友好。

I-GOS的热图包含更少的噪声。然而,这些热图中的像素落在分割掩模之外的可能性更高。

XRAI生成的热图受到分割结果的影响过大。GradCAM和GradCAM++产生更大的区域,这些区域不是那么对人类友好,但可以捕获足够的信息。

SIGCAM生成了所有方法中最吸引人的热图。热图比IGOS生成的热图包含更少的噪声,并捕获足够的信息来识别目标目标,如GradCAM和GradCAM++。更重要的是,SIGCAM的热图中的像素集中在分割任务中,使热图更加人性化。